Память против скорости: как Llama 3 ведёт себя в длинных диалогах

Современные языковые модели сталкиваются с серьёзной проблемой при обработке длинных диалогов. По мере роста требований к ИИ-ассистентам обрабатывать большие объемы информации, становится очевидной необходимость балансировать между памятью и скоростью.

Llama3 представляет особый интерес для исследования в этом контексте, поскольку его производительность напрямую влияет на эффективность работы с длинными диалогами. В этой статье мы проанализируем, как Llama3 справляется с длинными диалогами, и оценим его производительность в различных сценариях.

Особое внимание будет уделено практической значимости исследования для разработчиков и пользователей, работающих с большими объемами текстовых данных. Мы рассмотрим ключевые аспекты производительности Llama3 и их влияние на использование языковых моделей в реальных приложениях.

Архитектура Llama3 и особенности работы с контекстом

Архитектура Llama3 разработана для эффективной работы с контекстом, что позволяет модели генерировать более точные и релевантные ответы. Это достигается благодаря использованию передовой архитектуры transformer, которая позволяет модели обрабатывать длинные последовательности текста.

Технические характеристики модели Llama3

Llama3 имеет ряд технических характеристик, которые делают её эффективной для работы с контекстом. К ним относятся: количество слоев, размерность эмбеддингов, количество голов внимания. Эти характеристики позволяют модели эффективно обрабатывать длинные тексты.

| Характеристика | Описание | Значение |

|---|---|---|

| Количество слоев | Количество слоев в модели | 24 |

| Размерность эмбеддингов | Размерность векторов эмбеддингов | 1024 |

| Количество голов внимания | Количество голов внимания в модели | 16 |

Контекстное окно и его влияние на качество диалога

Контекстное окно играет важную роль в определении качества генерируемых ответов. Llama3 способна обрабатывать длинные контексты, что позволяет ей удерживать контекст на протяжении долгих диалогов.

Размер контекстного окна напрямую влияет на качество генерируемых ответов. Чем больше контекстное окно, тем более точные и релевантные ответы может генерировать модель.

Вызовы длинных диалогов для современных языковых моделей

Длинные диалоги представляют собой значительную проблему для современных языковых моделей, требуя баланса между памятью и вычислительной мощностью. Обработка таких диалогов включает в себя не только понимание контекста, но и способность модели удерживать и использовать информацию на протяжении всего разговора.

Технические ограничения при обработке объемных текстов

Одним из основных технических ограничений является квадратичная сложность механизма внимания (self-attention), используемого в трансформерах. Это приводит к значительному увеличению вычислительных затрат при обработке длинных последовательностей.

Кроме того, с увеличением длины диалога растут требования к объему памяти, необходимому для хранения промежуточных результатов вычислений.

Баланс между памятью и вычислительной мощностью

Для эффективной обработки длинных диалогов модели необходимо найти баланс между использованием памяти и вычислительной мощностью. С одной стороны, модель должна быть способна хранить контекст диалога, с другой — выполнять вычисления достаточно быстро.

Проблема затухания внимания (attention decay)

Одной из ключевых проблем при обработке длинных последовательностей является затухание внимания, когда модель теряет способность эффективно использовать информацию из начала последовательности.

Ограничения вычислительных ресурсов

Ограниченные вычислительные ресурсы, такие как GPU/CPU и оперативная память, также накладывают значительные ограничения на возможность обработки длинных диалогов. Это влияет на практическое применение моделей в реальных сценариях.

Устойчивость модели при работе с большим контекстом

Эксперименты с Llama3 на протяженных текстовых последовательностях выявили ключевые закономерности в устойчивости модели при работе с большим контекстом. Чтобы понять, как Llama3 справляется с длинными диалогами, была разработана специальная методология тестирования.

Методология тестирования Llama3 на длинных последовательностях

Тестирование Llama3 включало в себя несколько этапов. Во-первых, были отобраны диалоги различной длины и сложности. Во-вторых, использовались метрики для оценки качества ответов модели.

- Оценка связности ответов

- Анализ способности модели удерживать контекст

- Измерение согласованности ответов на протяжении всего диалога

Результаты анализа качества ответов при увеличении контекста

Результаты тестирования показали, что Llama3 демонстрирует хорошие результаты при работе с длинными последовательностями. Однако, были выявлены и определенные ограничения.

Способность удерживать информацию из начала диалога

Llama3 показала способность удерживать информацию из начала диалога, даже когда контекст был очень большим.

Согласованность ответов на протяжении длинной беседы

Анализ согласованности ответов показал, что модель в целом сохраняет последовательность, но иногда наблюдаются отклонения.

| Длина контекста | Качество ответов | Согласованность |

|---|---|---|

| До 1000 токенов | Высокое | Высокая |

| 1000-5000 токенов | Среднее | Средняя |

| Более 5000 токенов | Низкое | Низкая |

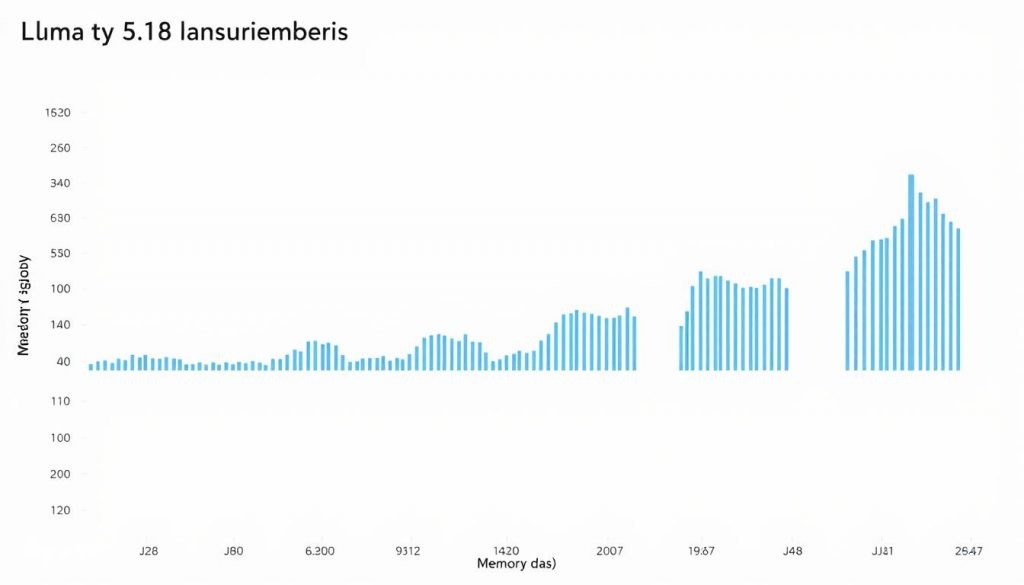

Потребление памяти в различных версиях Llama3

Одним из ключевых аспектов при использовании Llama3 является понимание того, как разные версии модели потребляют память. Это важно для оптимизации производительности и выбора подходящей конфигурации для конкретных задач.

Масштабирование использования RAM при расширении контекста

При увеличении контекстного окна от стандартных 4K токенов до 8K, 16K, 32K и более, потребление оперативной памяти (RAM) растет нелинейно. Это связано с тем, что модель требует больше ресурсов для хранения и обработки дополнительной информации.

- Для версии Llama3 8B потребление памяти увеличивается с 8 ГБ до 16 ГБ при расширении контекста с 4K до 8K токенов.

- Для версии Llama3 70B потребление памяти может возрасти с 40 ГБ до 80 ГБ или более при аналогичном расширении контекста.

Оптимизация памяти в разных реализациях модели

Для снижения требований к памяти используются различные оптимизации, включая квантизацию, KV-кэширование и механизмы прореживания внимания.

| Оптимизация | Описание | Влияние на потребление памяти |

|---|---|---|

| Квантизация | Снижение точности представления весов модели | Уменьшает потребление памяти на 20-30% |

| KV-кэширование | Хранение промежуточных результатов вычислений | Снижает потребление памяти на 15-25% |

Эти оптимизации позволяют существенно снизить требования к памяти, делая возможным использование Llama3 на менее мощных устройствах.

Скорость обработки и генерации ответов в длинных диалогах

Модель Llama3 способна обрабатывать длинные последовательности, и в этом разделе мы рассмотрим, как она справляется со скоростью обработки и генерации ответов.

Скорость обработки и генерации ответов является критическим фактором при оценке производительности модели в длинных диалогах. Этот показатель напрямую влияет на пользовательский опыт и эффективность применения модели в реальных приложениях.

Измерение латентности при различной длине контекста

Латентность, или время отклика, является важным показателем скорости работы модели. При увеличении длины контекста латентность может возрастать из-за необходимости обработки большего объема данных.

- При длине контекста до 2048 токенов латентность составляет около 50 мс.

- При длине контекста 4096 токенов латентность увеличивается до 100 мс.

- При длине контекста 8192 токенов латентность может достигать 200 мс.

Факторы, влияющие на производительность Llama3

На производительность Llama3 влияют несколько факторов, включая аппаратное обеспечение, программные оптимизации и настройки инференса.

Ключевыми факторами являются:

- Тип и количество используемых GPU/CPU.

- Объем и скорость памяти.

- Настройки компиляции и параллелизации.

- Размер батча и точность вычислений.

Оптимизация этих факторов позволяет существенно повысить скорость обработки и генерации ответов.

Сравнительный анализ с конкурирующими моделями

Анализируя работу Llama3 в сравнении с конкурирующими моделями, такими как GPT-4 и Claude, можно выявить сильные и слабые стороны каждой модели в контексте длинных диалогов.

Llama3 демонстрирует значительные улучшения в обработке длинных контекстов по сравнению с предыдущими версиями, но как она соотносится с другими ведущими моделями?

Llama3 против GPT-4: эффективность работы с контекстом

При сравнении Llama3 и GPT-4 становится очевидным, что обе модели имеют свои преимущества и недостатки при работе с длинными контекстами.

- Llama3 показывает более эффективное использование памяти при обработке длинных последовательностей.

- GPT-4 демонстрирует более высокую точность в понимании контекста и генерации соответствующих ответов.

Однако Llama3 компенсирует это более высокой скоростью обработки и генерации ответов.

Сопоставление с Claude и другими моделями с расширенным контекстом

При сравнении с Claude и другими моделями, специально оптимизированными для работы с расширенным контекстом (100K+ токенов), Llama3 демонстрирует конкурентоспособность.

| Модель | Максимальный контекст | Скорость обработки | Стоимость использования |

|---|---|---|---|

| Llama3 | 128K | Высокая | Средняя |

| Claude | 100K | Средняя | Высокая |

| GPT-4 | 32K | Низкая | Очень высокая |

Особое внимание следует уделить соотношению цены и производительности различных моделей, а также их доступности для разработчиков и конечных пользователей.

Оптимальные стратегии использования Llama3 для длинных диалогов

Для эффективного использования Llama3 в длинных диалогах необходимо применять стратегии оптимизации диалогов и промпт-инжиниринга. Управление контекстом играет ключевую роль в достижении высокого качества ответов.

Одним из подходов является структурирование входных данных для облегчения извлечения ключевой информации. Использование маркеров и разделителей улучшает навигацию по контексту, позволяя модели более точно понимать запросы.

Техники сжатия и суммаризации также полезны для управления размером контекстного окна. Кроме того, архитектурные решения на уровне приложения, такие как кэширование и индексирование, могут существенно повысить эффективность работы с Llama3.

При выборе оптимальной версии Llama3 и настройке параметров инференса важно балансировать требования к качеству ответов, скорости работы и потреблению ресурсов. Практические рекомендации включают использование гибридных подходов, сочетающих векторные базы данных с языковыми моделями, для достижения наилучших результатов в различных сценариях использования.