Почему Llama 3 выбирают для локального ИИ вместо облака

Развитие больших языковых моделей привело к тому, что искусственный интеллект перестал быть исключительно облачным сервисом. Всё больше компаний, разработчиков и технических специалистов осознанно переходят к локальному запуску ИИ-моделей. Одним из ключевых символов этого сдвига стала Llama 3 — модель, которую всё чаще выбирают именно для локального использования. Причина кроется не только в лицензии или технических характеристиках, а в изменении самого подхода к работе с ИИ. В этой статье подробно разберём, почему Llama 3 стала одним из главных выборов для локального ИИ и чем она выигрывает у облачных решений.

Что такое Llama 3 и как она изменила рынок ИИ

Llama 3 — это крупная языковая модель нового поколения, разработанная с расчётом на высокую производительность, гибкость и масштабируемость. В отличие от многих закрытых коммерческих моделей, она ориентирована на широкое использование, включая локальные среды. Это стало поворотным моментом для рынка, поскольку раньше мощные ИИ-модели практически всегда требовали облачной инфраструктуры.

С выходом Llama 3 стало очевидно, что локальный ИИ перестал быть экспериментом для энтузиастов. Модель изначально оптимизирована под запуск на пользовательском оборудовании, включая серверы, рабочие станции и даже продвинутые персональные компьютеры с GPU. Это позволило компаниям рассматривать ИИ не как внешний сервис, а как часть собственной инфраструктуры.

Важно и то, что Llama 3 демонстрирует качество генерации текста, сравнимое с облачными аналогами. Она уверенно справляется с аналитическими задачами, программированием, обработкой документов, созданием контента и диалогами. Таким образом, необходимость обращаться к облаку ради «качества» постепенно исчезает, а локальный запуск становится рациональным выбором.

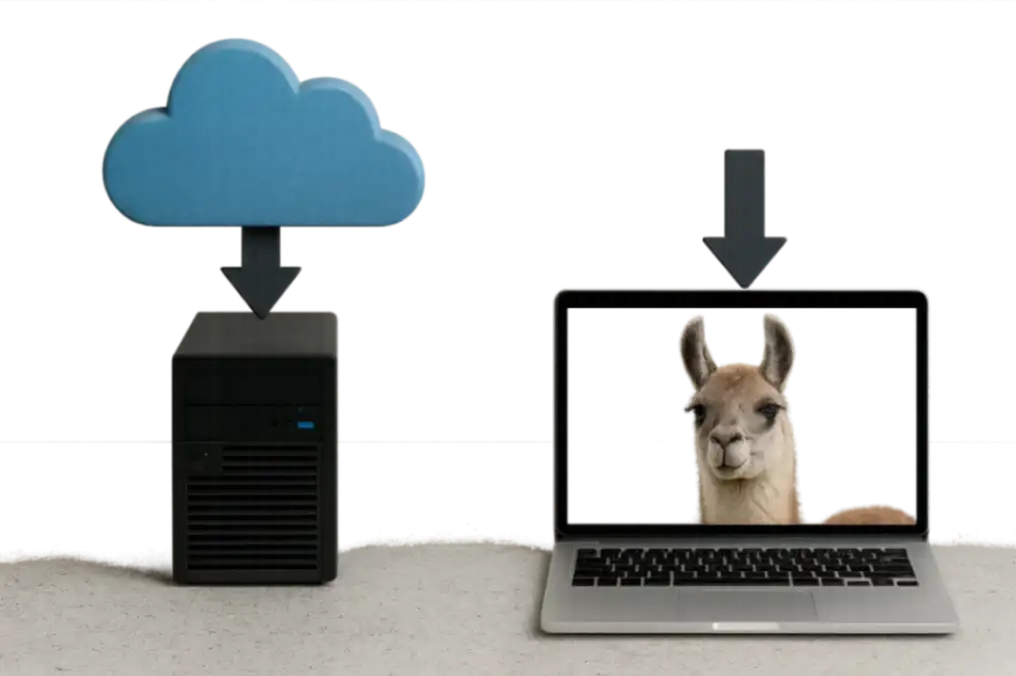

Локальный ИИ против облака: фундаментальные различия

Когда речь заходит о выборе между локальным и облачным ИИ, ключевыми становятся не только технические параметры, но и стратегические факторы. Облачные модели предлагают простоту старта, но накладывают ограничения, которые становятся критичными по мере роста проекта. Llama 3 идеально вписывается в альтернативную философию — полный контроль над ИИ-системой.

Локальный ИИ предполагает, что все данные, запросы и результаты обработки остаются внутри инфраструктуры пользователя. Это принципиально меняет подход к безопасности, стоимости и кастомизации. В случае облака пользователь всегда зависит от внешнего провайдера: от его тарифов, политики конфиденциальности, географии серверов и даже доступности сервиса.

Llama 3 как локальная модель даёт возможность строить ИИ-решения без постоянного подключения к интернету, без передачи данных третьим лицам и без риска внезапных изменений условий. Для бизнеса это означает устойчивость, а для разработчиков — свободу экспериментов и оптимизации.

Безопасность и конфиденциальность данных как ключевой фактор выбора

Одной из главных причин, по которой Llama 3 выбирают для локального ИИ, является вопрос безопасности данных. В эпоху строгих регуляций, таких как GDPR, HIPAA и корпоративные стандарты информационной безопасности, передача данных в облако часто становится проблемой. Даже при наличии договоров и шифрования остаётся фактор недоверия и юридических рисков.

Локальный запуск Llama 3 полностью исключает передачу данных внешним сервисам. Все запросы, документы, логи и результаты обработки остаются внутри компании или на устройстве пользователя. Это особенно важно для финансовых организаций, медицинских учреждений, юридических фирм и разработчиков, работающих с интеллектуальной собственностью.

Кроме того, локальный ИИ снижает риск утечек, связанных с человеческим фактором или уязвимостями облачной инфраструктуры. Администратор сам определяет уровни доступа, политики хранения данных и механизмы резервного копирования. В результате Llama 3 становится не просто моделью, а частью защищённого контура обработки информации.

Экономическая эффективность локального запуска Llama 3

На первый взгляд может показаться, что облачные ИИ-сервисы дешевле, поскольку не требуют инвестиций в оборудование. Однако при долгосрочном использовании ситуация меняется. Постоянные подписки, оплата за токены, лимиты и дополнительные сборы со временем превращаются в значительные расходы.

Локальный запуск Llama 3 требует первоначальных затрат на сервер или GPU, но затем модель работает без дополнительных платежей за каждый запрос. Это особенно выгодно для проектов с высокой нагрузкой: корпоративных чат-ботов, аналитических систем, внутренних ассистентов и генераторов контента.

Чтобы наглядно показать различия, рассмотрим сравнительную таблицу. Перед таблицей важно отметить, что сравнение проводится именно с точки зрения долгосрочного использования ИИ в бизнесе и разработке, а не краткосрочных тестов.

| Критерий | Llama 3 локально | Облачный ИИ |

|---|---|---|

| Стоимость при росте нагрузки | Фиксированная | Постоянно растёт |

| Передача данных | Отсутствует | Обязательная |

| Контроль над моделью | Полный | Ограниченный |

| Зависимость от провайдера | Нет | Да |

| Возможность кастомизации | Максимальная | Ограниченная |

После таблицы становится очевидно, что локальный ИИ на базе Llama 3 выигрывает в сценариях, где важны масштабирование и предсказуемость затрат. Особенно это актуально для стартапов и компаний, которые планируют активно использовать ИИ в своих процессах, а не эпизодически.

Гибкость, кастомизация и контроль над моделью

Одним из самых сильных преимуществ Llama 3 является возможность глубокой кастомизации. В облачных сервисах пользователь работает с уже настроенной моделью, параметры которой ограничены интерфейсом API. В локальной среде ситуация кардинально иная.

Разработчики могут дообучать Llama 3 на собственных данных, адаптировать её под конкретные домены, менять системные промпты, управлять токенизацией и логикой ответа. Это делает модель не универсальным инструментом «на все случаи», а специализированным ИИ-движком под конкретные задачи.

Уместно выделить основные направления, в которых локальная Llama 3 даёт наибольшую свободу. Перед списком важно подчеркнуть, что речь идёт не о теоретических возможностях, а о практических сценариях, которые уже используются в компаниях и командах разработчиков:

- дообучение модели на внутренних документах и базах знаний без утечки данных.

- интеграция с локальными системами, CRM и корпоративным ПО.

- настройка поведения ИИ под конкретные бизнес-процессы и стиль общения.

- оптимизация скорости и потребления ресурсов под конкретное железо.

После списка стоит отметить, что именно эта гибкость превращает Llama 3 в стратегический инструмент. Она позволяет выстроить ИИ-экосистему, которая развивается вместе с компанией, а не зависит от решений внешнего вендора.

Техническая зрелость и производительность Llama 3

Выбор Llama 3 для локального ИИ обусловлен не только философией открытости, но и её технической зрелостью. Модель демонстрирует высокую эффективность при работе на современных GPU и поддерживает различные режимы оптимизации, включая квантование и распределённые вычисления.

Это означает, что Llama 3 может запускаться как на мощных серверных конфигурациях, так и на более доступном оборудовании. Такой диапазон сценариев делает модель универсальной для разных уровней проектов — от индивидуальных разработчиков до крупных корпораций.

Кроме того, локальный запуск позволяет добиться минимальной задержки отклика. В отличие от облака, где каждый запрос проходит через сеть и инфраструктуру провайдера, Llama 3 отвечает напрямую, что критично для интерактивных систем и внутренних инструментов.

Будущее локального ИИ и роль Llama 3

Тенденция к локальному ИИ будет только усиливаться. Рост вычислительных мощностей, развитие open-source экосистем и ужесточение требований к данным делают облачные модели менее универсальным решением. Llama 3 идеально вписывается в этот тренд, предлагая баланс между качеством, свободой и безопасностью.

Для разработчиков это означает возможность строить независимые ИИ-продукты. Для бизнеса — снижение рисков и контроль над ключевыми технологиями. Для пользователей — уверенность в том, что их данные остаются под их контролем.

Заключение

Llama 3 выбирают для локального ИИ не случайно. Она стала ответом на ограничения облачных моделей, предложив альтернативу, основанную на контроле, безопасности и экономической эффективности. Возможность запускать мощную языковую модель локально меняет саму архитектуру ИИ-решений и делает их более устойчивыми.

По мере развития технологий именно такие модели будут формировать основу нового поколения интеллектуальных систем, где ИИ — это не внешний сервис, а полноценная часть инфраструктуры.